이번 세션에서는 확률적 경사하강법에 대해 학습했습니다.

머신러닝이나 딥러닝에서 모델을 설계할 때 좋은 성능을 보여주기 위해서는 하이퍼 파라미터를 최적화 시켜야 합니다. 이때 조정하는 파라미터는 에포크, 내부 노드 등 여러 파라미터가 있지만 그 중에 가장 드라마틱하게 성능을 바꿔주는 파라미터를 optimizer라고 합니다.

optimizer는 train 데이터셋을 이용하여 모델을 학습할 때 데이터의 실제 결과와 모델이 예측한 결과를 기반으로 잘 줄일 수 있게 만들어주는 역할을 합니다. 예를 들어 네비게이션에서 최적의 경로를 고르는 방식 중 큰 길 위주의 경로, 최단거리, 무료 길 등 여러 알고리즘이 optimizer 종류와 비슷한 역할을 한다고 볼 수 있습니다.

optimizer의 종류는 경사 하강법(Gradient Descent), 확률적 경사 하강법(Stochastic Gradient Descent, SGD), Momentum, Nesterov Accelerated Gradient (NAG), Adam, AdaGrad, RMSProp, AdaMax, Nadam 등

여러 종류가 있으나 이번 세션에서는 경사하강법을 중점적으로

알아보았습니다.

좌표하강법(Coordinate descent)란 i번째 원소만을 변수로 보고 나머지 변수는 고정값으로 본 뒤 f(x)를 최소화하는 xi를 찾는 방식입니다.

경사하강법 (Gradient descent)이 어떤 함수의 최솟값을 향한 방향을 계산하는데 1차 미분을 사용하는 반면 뉴턴 방법 (Nexton's method)은 2차 미분을 사용합니다. 따라서 뉴턴 방법이 경사하강법 보다는 성능이 훨씬 좋습니다.

뉴턴 방법은 최적화 변수의 시작값 x에서 목적 함수 f(x)를 테일러 시리즈로 전개 후 2차 함수로 근사화하고, 이 근사함수의 최솟값을 구하기 위해 미분해주는 방식으로 진행됩니다.

해당 점에서 접하는 2차 함수의 최소 화원으로 가중치를 업데이트하는 뉴턴 방법

경사하강법 (Gradient descent)은 접선의 기울기인 미분값을 이용하여 극소값을 구하는 방법입니다.

함수의 최솟값 위치를 찾기 위해 정의한 step size만큼 움직이며 최적의 파라미터를 찾을 때까지 밑의 식을 반복합니다.

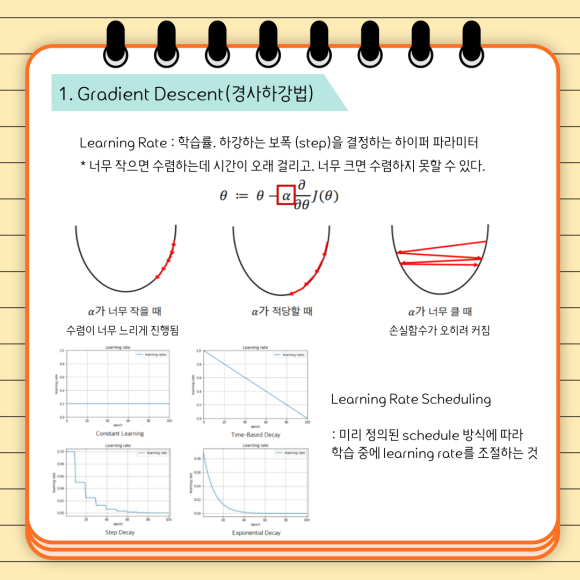

경사하강법에서 learning rate란 학습률로, 하강하는 보폭을 결정하는

하이퍼 파라미터 입니다. (위 식에서 a)

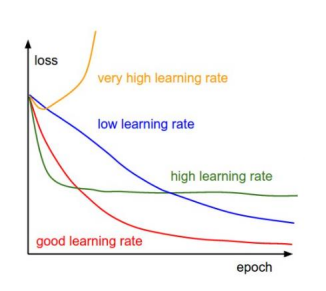

학습률이 너무 작으면 수렴하는데 시간이 오래 걸리고,

너무 크면 극점을 건너뛰어 수렴하지 못할 수 있습니다.

보통 0.01로 설정 후 학습해보고 학습 결과가 발산하면 값을 줄이고,

학습 시간이 너무 오래 걸리면 큰 값으로 설정합니다.

Learning Rate Scheduling 이란 미리 정의된 Schedule 방식에 따라 학습 중에 learning rate를 조절하는 것으로 Constant Learning Rate, Time-Based Decay, Step Decay, Exponential Decay, Adaptive Learning Rate Methods 등이 있습니다.

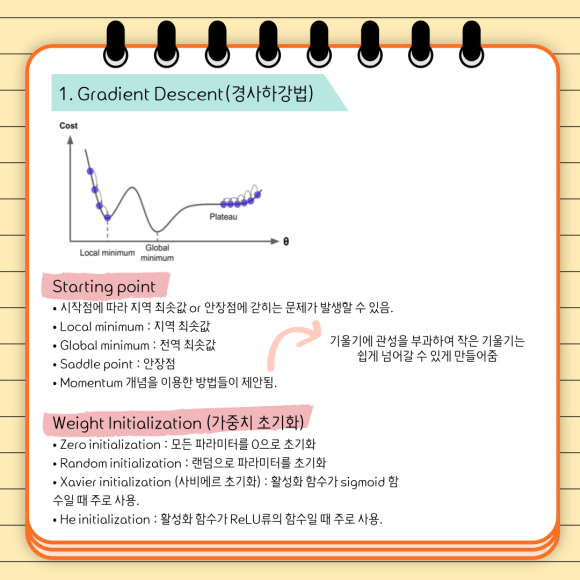

시작점이 어디 있느냐에 따라 전역 최솟값에 수렴하는 것이 아닌 지역 최솟값이나 안장점에 갇히는 문제가 발생할 수 있는데, 이를 방지하기 위해 기울기에 관성을 부여하여 작은 기울기는 쉽게 넘어갈 수 있게 해주는 Momentum 개념을 이용한 방식이 제안되었습니다.

첫 위치를 잘 정해서 좋은 학습을 하기 위해 시작 지점의 가중치를 잘 정해주려면 상황에 맞는 가중치 초기화 방법을 사용하게 됩니다. 가중치를 초기화하는 방시에는 첫째로 모든 파라미터 값을 0으로 놓고 시작하는 Zero initialization이 있습니다. 그러나 신경망의 파라마터 값이 모두 같다면 갱신을 하더라도 모두 같은 값으로 변하게 되므로 여러개의 노드로 신경망을 구성하는 의미가 사라집니다. 그렇기 때문에 초기값은 무작위로 설정해야 합니다.

이렇게 무작위로 설정해주는 방법을 Random initialization이라고 합니다.

그러나 이 경우에도 모든 노드의 활성화 함수의 출력값이 비슷하면 노드를 여러 개로 구성하는 의미가 사라지게 됩니다.

이러한 문제를 해결하기 위해 고안된 초기화 방식이 Xavier initialization입니다.

사비에르 초기화에서는 고정된 표준편차를 사용하지 않고, 이전 은닉층의 노드 수에 맞추어 변화시킵니다. 이러한 방식을 사용하면 층마다 노드 개수를 다르게 설정하더라도 이에 맞게 가중치가 초기화되기 때문에 고정된 표준편차를 사용하는 것보다 훨씬 더 강건합니다.

He initialization이란 ReLu 함수를 활성화 함수로 사용할 때 추천되는 초기화 방법으로, 활성화 함수에 따라 적절한 초기화 방법이 달라집니다.

에포크란 훈련 데이터셋에 포함된 모든 데이터들이 한번씩 모델을 통과한 횟수로, 전체 학습 데이터셋을 학습하는 횟수입니다.

에포크를 높일수록 손실값이 감소하여 적절한 학습률에서 적합한 파라미터를 찾을 확률이 올라갑니다. 그러나 에포크를 지나치게 높이게 되면 훈련 데이터셋에 과적합되는 문제가 발생하므로 이 경우에는 최적점의 에포크로 다시 훈련하거나 학습 진행에 따라 조기 종료하는 방식을 사용합니다.

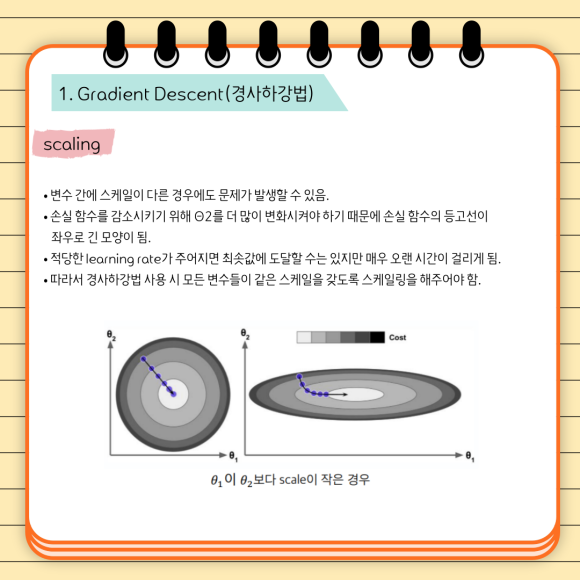

머신러닝을 위한 데이터셋을 정제할 때, 특성별로 데이터의 스케일이 다른 경우 머신러닝 과정에서 문제가 발생할 수 있기 때문에 스케일링 작업을 통해 모든 특성의 범위 또는 분포를 같게 만들어 주어야 합니다.

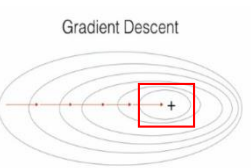

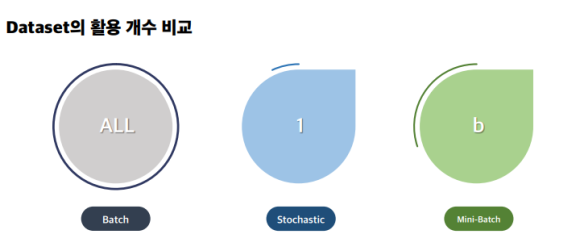

경사하강법은 전체 데이터셋을 모두 사용하여 기울기를 계산하기 때문에 데이터셋의 크기가 큰 경우 학습 시간이 오래 걸려 매우 비효율적입니다.

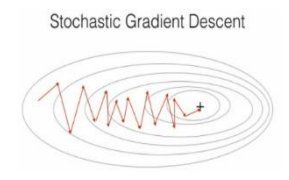

이 방식을 Batch Gradient Descent라고 하는데, 데이터가 많을 경우 계산 비용이 과다해집니다. 그래서 사용하는 방식은 모든 데이터셋이 아닌 한개의 무작위 데이터셋을 이용하여 경사하강을 진행하는 Stochastic Gradient Descent로, Batch 방식에서 발생하는 계산 비용 문제를 해결하기 좋습니다.

위의 수도코드에 나와있듯 모든 샘플이 theta의 최적화에 영향을 미치는 것이 Batch Gradient Descent 방법이며, 위 그림과 같이 매 iteration마다 최적의 파라미터를 찾아가며 global minimum을 향합니다.

그에 반해 확률적 경사하강법은 하나의 데이터셋에 대한 Cost를 계산한 후 경사하강을 진행합니다.

이 경우 아래와 같이Noise가 발생하지만 최적의 파라미터에 매우 근접하게 됩니다.

확률적 경사하강법은 연식 시간이 비교적 빨라 수렴속도가 빠르고 계산 시 메모리 비용이 절약된다는 장점이 있으나, 샘플의 선택이 확률적이며 심한 Noise 때문에 global minimum을 찾지 못할 가능성이 존재합니다.

이 경우 사용하는 방식이 b개의 데이터셋에 대한 Cost를 계산하는 Mini-batch 방식입니다. b가 10이라면, i~i+9번째 example에 대한 미분항을 계산 후 모든 m에 대해 Parameter를 최적화합니다.

일반적으로 b = 10이나, 2~100사이에서 선택 가능하며 Stochastic보다 병렬처리에 유리하기 때문에 성능 향상을 기대할 수 있습니다.

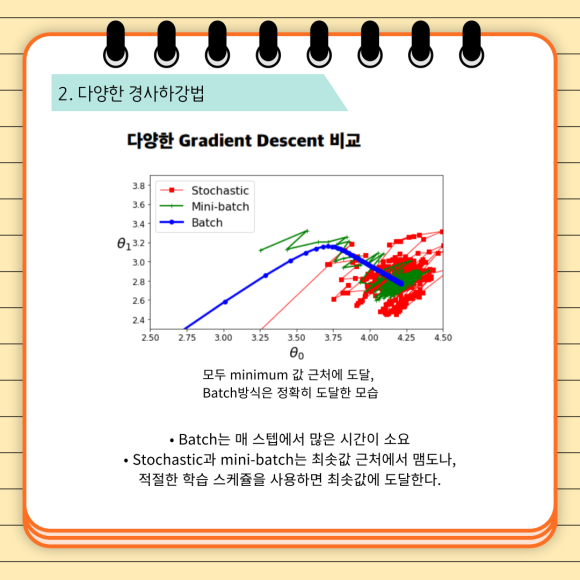

세 방식을 비교해보면 모두 minimum 값 근처에 도달했으며, batch 방식은 정확히 도달한 것을 볼 수 있습니다. Stochastic과 mini-batch는 최솟값 근처에서 맴도나, 적절한 학습 스케쥴을 사용하면 최솟값에 도달합니다.

이상으로 9기 7주차 정규세션을 복습해보았습니다!

다음 시간에는 Decision Tree, 교차검증, 하이퍼파라미터 튜닝에 대해 공부할 예정입니다🥰

'BITAmin 9기🍊' 카테고리의 다른 글

| [BITAmin] 9주차 - 트리 (0) | 2022.12.18 |

|---|---|

| [BITAmin] 6주차 - 로지스틱 회귀 (0) | 2022.10.02 |

| [BITAmin] 5주차 - 회귀 알고리즘 복습 및 심화, 관련 실습 (0) | 2022.08.06 |

| [BITAmin] 4주차 - 특성공학과 규제 (0) | 2022.08.05 |

| [BITAmin] 3주차 K-최근점 이웃 회귀, 선형 회귀 (0) | 2022.06.27 |